Relatori: Ing. Luigi Capone

Cari amici, che serata! Io non sono sicuro che in una serata “in presenza” (alla pandemia dobbiamo anche questo neologismo…) avremmo avuto la stessa attenzione. Argomento “tosto” e oratore competente al punto da esporre una materia complessa in modo chiaro; “in presenza”, distratti dalle attrazioni della tavola di fine serata, dalla stanchezza o dal piacere di condivisione del personale con i nostri vicini, forse non si sarebbe registrata analoga attenzione e concentrazione.

Vantaggi di Zoom, col quale l’attenzione è “aumentata”: un primo effetto dell’intelligenza artificiale? Lo vedremo.

All’inizio, forse per merito di Luigi, la definizione di A.I. (acronimo di Artificial Intelligence) non appare particolarmente complessa né fantasiosa: A.I. è un sistema di hardware e software programmati per rendere prestazioni normalmente “umane”.

Il difficile viene dopo.

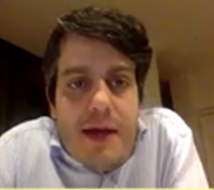

Per brevità, Luigi circoscrive il campo della propria relazione al “machine learning” ed al “deep learning”, accennando soltanto all’universo A.I.: sistemi esperti, linguaggio umano, riconoscimento vocale, programmazione, robotica, visione e riconoscimento di immagini.

Ebbene, la “cassetta degli attrezzi” per affrontare l’A.I. comprende una moltitudine di discipline, tale da stupirci già con l’elencazione delle principali: Statistica; Algebra lineare; Analisi matematica lineare e non-lineare; Logica; Linguistica; Informatica; Ingegneria del software; Calcolatori elettronici; Calcolo parallelo. Le conoscete tutte, almeno di nome? Non credo.

Questi ed altri attrezzi servono per imitare l’Indagine ed il comportamento dell’uomo. In sintesi:

- il sapere scientifico dell’uomo è basato sul metodo sperimentale. Gli scienziati sintetizzano tramite equazioni le relazioni tra quantità fisiche, la cui validità deve essere verificata sperimentalmente. Tali equazioni permettono di calcolare nuovi scenari reali.

- L’A.I. analizza grandi quantità di dati reali, ne estrae informazioni che, inserite in algoritmi, permettono di: - replicare comportamenti complessi; - predire quantità di interesse; -estrarre relazioni nascoste tra le variabili.

Processi come vedete con diverse analogie e riassumibili nel binomio “prova-errore”.

A forza di sentirne parlare si potrebbe pensare che l’A.I. sia una scoperta recente, ma non è affatto così.

Turing, nel 1950, si poneva la domanda “le macchine possono pensare?” rispondendosi “dipende da cosa intendiamo per ‘pensiero’ e per ‘macchine’”. Quindi, l’A.I. è innanzitutto filosofia.

Ma era ancora il 1943 quando McCulloch e Pitts introdussero l’idea di utilizzare reti neurali come macchine computazionali; e nel 1949 Hebb descrisse la plasticità sinaptica come capacità del sistema nervoso di modificare l'intensità delle relazioni interneuronali - sinapsi -, di instaurarne di nuove, e di eliminarne alcune.

Pochi anni dopo, nel 1955, l’A.I. divenne addirittura una disciplina accademica. Nondimeno, il progresso della disciplina risultò fin troppo veloce, perché la capacità di calcolo dell’hardware non gli teneva passo. Occorrevano infatti computers sempre più potenti (e costosi), al punto che nei primi anni ‘70 la DARPA (agenzia militare di ricerca USA) tagliò sensibilmente i finanziamenti per la ricerca nel campo dell’A.I. Lo stesso fece la Gran Bretagna e per un po' di A.I. non si sentì parlare. Consideriamo che fino ad allora la prospettiva prevalente, nel campo dell’A.I., era quella militare.

Dovemmo arrivare alla fine degli anni ’90 per veder risorgere quell’interesse, applicato stavolta all’invenzione che più d’ogni altra aveva cambiato le nostre abitudini nel secolo scorso: l’automobile. Guida assistita, guida autonoma o semiautonoma, macchine automatiche di Google che giravano per le strade del mondo mappandolo in 3D, finché, nel 2007, la DARPA rilanciò un progetto di veicoli a guida autonoma, spinta anche dalle major. Nel 2010 nascono Google Image Search, Google Translate, Alpha Go, Watson, e l’A.I. diviene realtà applicata, in rapido incremento. Infatti:

- la potenza computazionale aumenta;

- i prezzi per infrastrutture computazionali sono accessibili grazie ai servizi Cloud;

- I provider cloud forniscono funzionalità di intelligenza artificiale pre-confezionate adattabili alle esigenze del singolo;

- esiste disponibilità di enormi quantità di dati nei sistemi aziendali e governativi.

E fin qui ci siamo capiti; più complicato capire come funziona un processo di A.I.: non a caso Luigi avverte: “The Devil is in the Details”.

Come facciamo allora a costringere le macchine ad imparare?

Primo passo, apprendimento monitorizzato. Diamo in pasto ad un algoritmo dati di input e di output, ossia il problema e la soluzione, che ci sono già noti. L’algoritmo viene indotto a computare la relazione tra input e output; quando ha imparato, gli si dà un nuovo input, e lui produce un output simulando la funzione reale.

Secondo passo: Apprendimento autonomo: algoritmo ha a disposizione dati non pre-classificati, e ne deve individuare autonomamente i modelli di correlazione. Ed il bello è che ci riesce.

Terzo passo: apprendimento rinforzato: l’algoritmo interagisce con l’ambiente, e viene premiato quando indovina e punito quando sbaglia. Non vi ricorda il vostro cane?

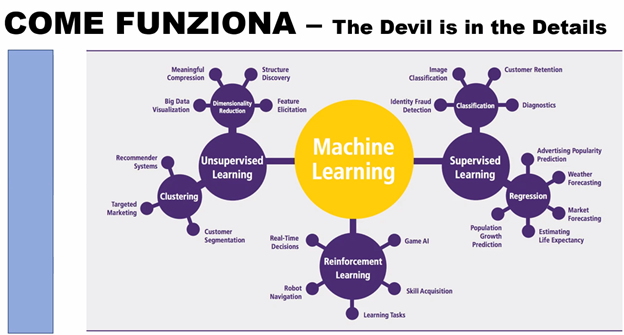

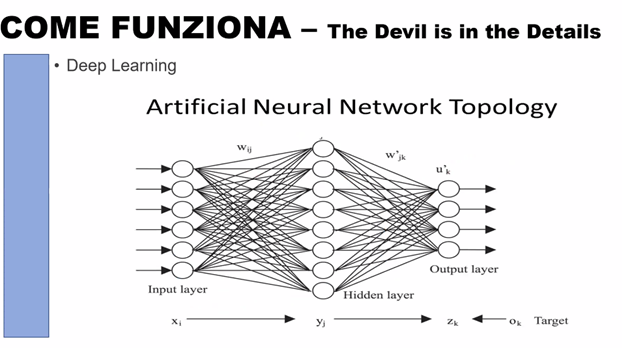

Sempre più difficile, il “deep learing”, ossia apprendimento profondo. Qui entra in gioco un altro meccanismo imitativo dell’uomo, ossia la rete neurale di McCulloch e Pitts.

È un modello matematico-informatico di calcolo costituito da gruppi di interconnessioni di informazioni sullo stile neuroni artificiali. Una funzione matematica è definita come una composizione di altre funzioni ... a loro volta composte da altre funzioni. Tutto questo viene rappresentato come una struttura di reti, con le frecce raffiguranti le dipendenze tra variabili.

In termini pratici le reti neurali sono strutture non-lineari di dati statistici organizzate come strumenti di modellazione. Esse possono essere utilizzate per simulare relazioni complesse tra ingressi e uscite che altre funzioni analitiche non riescono a rappresentare.

Cosa ci possiamo fare? Di tutto; assistenti personali; robots; analisi dei gusti dei consumatori; valutazione dei rischi; lettura dei testi; realtà aumentata. Quello che fa l’uomo, ma di più, più velocemente, e su base dati immensamente maggiore.

Il linguaggio di programmazione Python consente la traduzione simultanea, le predizioni, la guida automatica, la diagnostica per immagini, la lettura labiale, elaborazione di immagini anche con effetti psichedelici (inception, deep dreaming).

Google, Apple, Intel, Microsoft, Amazon utilizzano l’A.I. già da anni, e molto può essere ancora fatto. Il futuro è agganciato alla potenza di calcolo, che potrebbe aumentare vertiginosamente con la tecnologia quantistica. Non bisogna farsi sfuggire queste potenzialità, pur consapevoli di doverne fare un uso eticamente accettabile, magari regolamentato a livello internazionale.

Molte le domande: Luca Faotto esordisce chiedendo se nientemeno che la coscienza possa essere “copiata” dalla A.I. Per nulla sconvolto dagli aspetti filosofici, Luigi risponde, alla maniera di Turing, che dipende: è la coscienza rappresentabile con modelli matematici, quantitativi? Finché non si potrà fornire una risposta affermativa dobbiamo dire di no. Per il momento … domani chissà.

Cesare Parazzi chiede se non sia tutto sommato banale il meccanismo dell’A.I., riducendosi ad elaborazioni statistiche di una gran mole di dati; è vero, ammette Luigi, ma nell’applicazione reale la complessità non manca; si pensi al computer, che tutto sommato è una macchina che – banalmente - sa fare solo addizioni, eppure …

Alfonso Amato chiede chiarimenti sul linguaggio Python, inizialmente piuttosto lento; Luigi ammette questa lentezza, dovuta alla facilità del suo linguaggio di programmazione, ma la linea gli cade rovinosamente prima di concludere, consentendo però a sua moglie Olga di consigliarci la lettura di “Macchine come me” di Ian McEwan, storia di un robot programmato per non mentire, il che provoca grossi guai ai suoi proprietari (Alfonso ricorda il film di Alberto Sordi “Io e Caterina”). Ristabilito il collegamento, Luigi conclude affermando che il linguaggio CPU è ormai quello più in uso per l’A.I.

Craig chiede come Accenture intervenga nel campo dell’A.I.; Luigi ci informa che Accenture ha una divisione appositamente addetta. Interessante apprendere che è possibile valutare, nei colloqui di recruiting, se il candidato stia mentendo, e addirittura se un candidato stia copiando da files del proprio computer durante una interrogazione.

Adriano Anderloni ipotizza una perdita di posti di lavoro, che invece secondo Luigi diviene più che altro una trasformazione del lavoro, con perdite limitate alle mansioni meno elevate e complesse. Negli USA, per esempio, è molto meno diffusa la paura di non poter trovare un nuovo lavoro o comunque riconvertirsi.

È stato quindi il mio turno, per chiedere l’impatto dell’A.I. sul campo giudiziale, in particolare sui sistemi predittivi e sull’uso dell’A.I. negli studi legali, ricordando che già il 9 marzo 2017 Gianfranco D’Aietti ci aveva illustrato un sistema esperto, di sua realizzazione, per il calcolo degli assegni di separazione e divorzio. Secondo Luigi avvocati e commercialisti vedranno un forte ingresso dell’automazione nei loro servizi; uno studio milanese già da qualche temo ha acquisito un algoritmo, ma al momento non è possibile ancora valutarne il rapporto costi-benefici. Certamente molte attività ripetitive saranno automatizzate, ma altre di grande complessità resteranno “umane”. Craig ricorda come la denunzia dei redditi negli USA si faccia on line in pochi minuti e costi circa 60 dollari ed io incalzo Luigi fino a convenire che l’A.I. funzionerà forse meglio di quella umana, salvo ove assumesse a modello esempi umanamente … “scadenti”.

Molto simpaticamente, domande e risposte si sono fuse in una conversazione che ci ha portato a sapere che Luigi ha scelto discipline scientifiche proprio per sottrarsi alla imprecisione, se non vaghezza, di quelle umanistiche, tipo la giurisprudenza.

New entry di Matteo Borioli, che ricorda l’esempio di algoritmi usati per pubblica sicurezza, che risultarono “viziati” da input discriminatori se non addirittura razzisti, e Luigi conferma che l’algoritmo non può che seguire gli input che gli vengono dati, anche se … sbagliati.

Maurizio Agnesa ha infine posto un quesito sottile, che gli ha meritato l’apprezzamento di Luigi: come psicologo del lavoro ricorda che l’enforcement learning è stato descritto già nel 1938 da B.F. Skinner, e proprio nel 1970, quando l’A.I. era in calo, si diffondeva la psicologia cognitiva, descrittiva dell’human information processing, parzialmente debitrice dell’A.I. Gli studi sul conoscitivismo vengono utilizzati in A.I.? Luigi trova molto stimolante la domanda, ma deve ammettere che la psicologia cognitiva è una disciplina negletta negli studi sull’A.I., salvo alcuni studi sul funzionamento della corteccia cerebrale e la memoria.

Insomma: serata tostissima, ma affascinante e da apprezzare ancor di più in quanto offerta dalle “risorse proprie” del nostro amato Club. È vero, Luca, siamo ancora la miglior macchina esistente, specie … nel R.C. Milano Castello.

Massimo Burghignoli